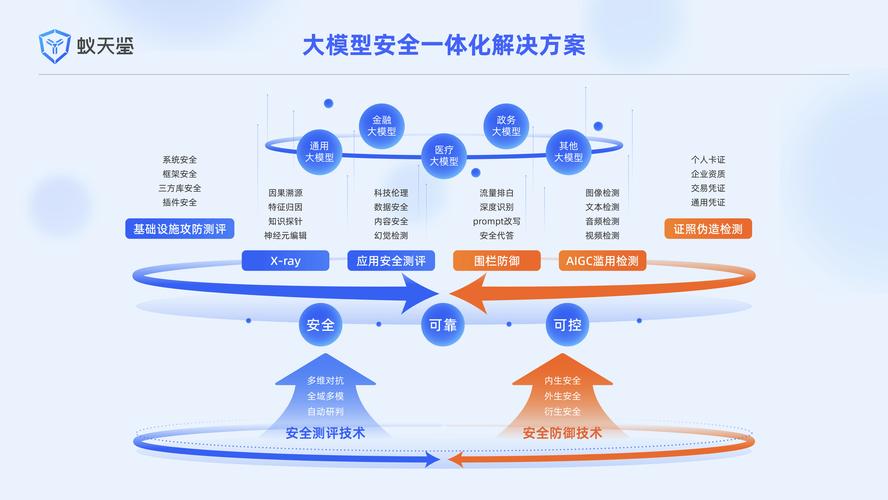

AI模型安全性對比評測正在進行,旨在全面評估不同AI模型在安全性方面的表現(xiàn),通過對比各模型在數(shù)據(jù)保護、隱私安全及抵御攻擊等方面的能力,為行業(yè)提供有價值的參考,助力構建更安全的AI應用環(huán)境。

AI模型安全性那些事兒:別讓你的智能助手變“內(nèi)鬼”

嘿,朋友們,今天咱們得聊聊一個挺嚴肅的話題——AI模型的安全性,你瞅瞅現(xiàn)在,AI技術那是遍地開花,從智能家居到自動駕駛,從醫(yī)療診斷到金融風控,哪兒哪兒都離不開它,但話說回來,這AI模型要是出了安全問題,那可就麻煩大了,簡直就像家里養(yǎng)了個“內(nèi)鬼”,防不勝防啊!

先說說這AI模型安全性的重要性吧,你想啊,現(xiàn)在咱們的個人信息、企業(yè)機密,甚至國家的安全數(shù)據(jù),都有可能被AI模型處理,要是這模型被黑客盯上了,或者它自個兒就“腦子瓦特”了,那數(shù)據(jù)泄露、隱私侵犯、決策失誤,啥事兒都能發(fā)生,就像之前有個醫(yī)療AI系統(tǒng),因為模型訓練數(shù)據(jù)有偏差,結果給病人誤診了,差點兒就出大事兒,這事兒一出來,大家都驚了,原來AI模型也不是那么靠譜兒啊!

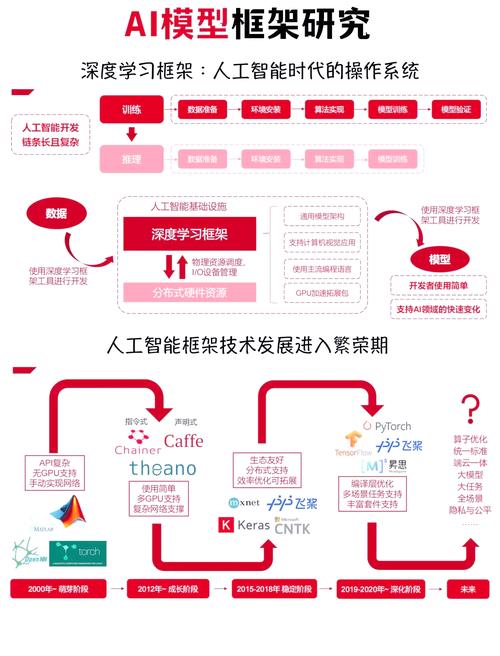

那AI模型安全性到底包括哪些方面呢?我覺著啊,主要就是數(shù)據(jù)安全和模型安全兩大塊兒,數(shù)據(jù)安全,那就是得保證訓練數(shù)據(jù)不被泄露、不被篡改,你想啊,要是訓練數(shù)據(jù)里混進了啥惡意代碼,或者數(shù)據(jù)被人家偷偷拿走了,那模型學出來的東西能靠譜嗎?肯定不行啊!模型安全呢,就是得保證模型本身不被攻擊、不被利用,防止模型被惡意輸入給繞過去,或者模型參數(shù)被人家偷走了,拿去干壞事兒。

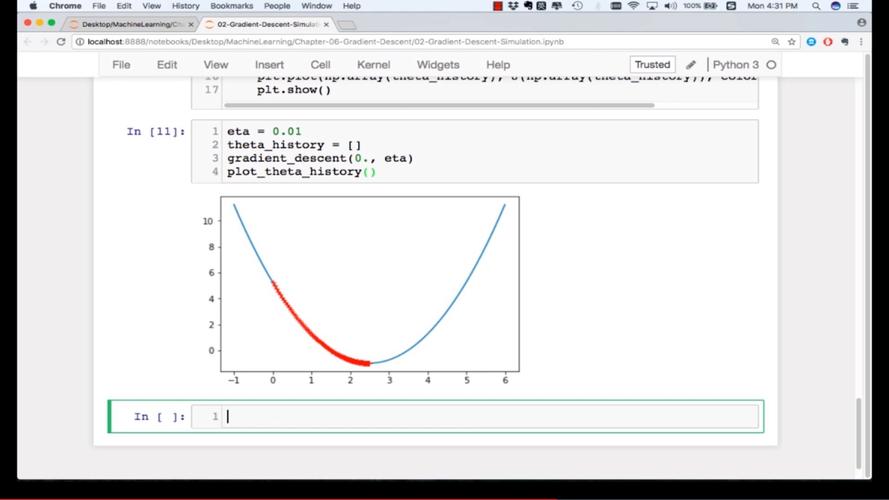

咱們再來說說這AI模型安全性面臨的挑戰(zhàn)吧,現(xiàn)在啊,這挑戰(zhàn)可多了去了,首先就是數(shù)據(jù)隱私問題,你瞅瞅現(xiàn)在的大數(shù)據(jù)時代,個人信息滿天飛,要是這些數(shù)據(jù)被AI模型給泄露了,那可就麻煩了,有些APP會收集用戶的瀏覽記錄、購買習慣啥的,要是這些數(shù)據(jù)被不法分子拿到了,那用戶可就遭殃了,其次呢,就是模型的可解釋性問題,你想啊,AI模型學出來的東西,有時候咱們?nèi)祟惗伎床欢鼊e說去判斷它是不是安全了,要是模型出了啥問題,咱們連原因都找不到,那可就真成“瞎子摸象”了。

那怎么辦呢?別急,我這兒有幾個招兒,首先啊,就是得加強數(shù)據(jù)保護,對訓練數(shù)據(jù)進行加密處理,防止數(shù)據(jù)泄露;對模型輸入進行嚴格的校驗和過濾,防止惡意輸入;對模型輸出進行監(jiān)控和審計,及時發(fā)現(xiàn)并處理異常,其次呢,就是得提高模型的可解釋性,用可視化的方法展示模型的決策過程,讓咱們?nèi)祟惸芸炊挥每山忉屝缘乃惴▉碛柧毮P停屇P蛯W出來的東西更透明、更可靠。

再來說說這AI模型安全性的實踐案例吧,有個電商平臺,之前就因為AI模型安全性問題吃了大虧,他們那個推薦系統(tǒng)啊,本來是想給用戶推薦好東西的,結果因為模型訓練數(shù)據(jù)有偏差,給一些用戶推薦了不合適的產(chǎn)品,導致用戶流失嚴重,后來啊,他們加強了數(shù)據(jù)保護,提高了模型的可解釋性,還對模型進行了定期的安全評估和更新,現(xiàn)在啊,那個推薦系統(tǒng)可好用了,用戶滿意度也大大提高了。

還有啊,現(xiàn)在有些金融機構也在用AI模型來評估貸款風險,這模型要是出了安全問題,那可就麻煩大了,要是模型被黑客攻擊了,給一些信用不好的人放了貸,那金融機構可就虧大了,所以啊,這些金融機構也得加強AI模型的安全性管理,保證模型的安全可靠。

說了這么多啊,我想給大家提個醒兒,AI模型安全性這事兒啊,可不是小事兒,咱們得時刻關注著它的發(fā)展動態(tài)啊,得不斷學習新的安全技術和方法啊,只有這樣呢,咱們才能確保AI模型在安全的環(huán)境下運行啊,才能讓它真正成為咱們的智能助手啊,而不是“內(nèi)鬼”。

最后啊,我想說啊,AI模型安全性這事兒啊,得靠咱們大家共同努力啊,政府得加強監(jiān)管啊,企業(yè)得加強自律啊,咱們用戶也得提高安全意識啊,只有這樣呢,咱們才能共同營造一個安全、可靠的AI應用環(huán)境啊,好了啊,今天就跟大家聊到這兒吧啊,希望大家都能重視起AI模型安全性這事兒來啊!