AI模型延遲文檔資料,聚焦AI模型運(yùn)行中的延遲問題,深入剖析其成因、影響及優(yōu)化策略,該資料為AI開發(fā)者提供寶貴參考,助力提升模型性能,優(yōu)化用戶體驗,推動AI技術(shù)高效發(fā)展。

AI模型延遲?這事兒得好好嘮嘮!

嘿,朋友們!今天咱們來聊聊一個挺讓人頭疼的話題——AI模型延遲,你可能沒直接聽過這個詞兒,但要是你在用AI相關(guān)的應(yīng)用時,感覺反應(yīng)慢半拍,或者結(jié)果出來得磨磨唧唧,那很可能就是AI模型延遲在搗鬼。

啥是AI模型延遲?

咱先整明白,AI模型延遲到底是個啥玩意兒,簡單說,就是你給AI模型輸入一個指令或者數(shù)據(jù),它得花點(diǎn)兒時間處理,然后才能給你結(jié)果,這個時間差,就是延遲,就好比你去餐廳吃飯,點(diǎn)菜之后,服務(wù)員得把菜單送到廚房,廚師再開始做菜,最后菜才能端到你桌上,這中間的時間,就跟AI模型延遲差不多。

AI模型延遲可不是個小問題,你想啊,要是你在玩一個用AI技術(shù)做的游戲,關(guān)鍵時刻技能放不出來,就因為AI模型延遲,那得多鬧心吶!再比如說,你在用智能語音助手,你說完話,它半天沒反應(yīng),或者反應(yīng)錯了,這體驗?zāi)芎脝幔靠隙ú荒馨。?/p>

AI模型延遲是咋產(chǎn)生的?

那AI模型延遲是咋來的呢?這里面門道可不少。

數(shù)據(jù)量大是個大問題,現(xiàn)在AI模型處理的數(shù)據(jù)量那是相當(dāng)龐大,就好比一個倉庫里堆滿了貨物,AI模型得一件一件地檢查、處理,要是貨物太多,倉庫又小,那處理起來肯定慢啊,比如說,在圖像識別領(lǐng)域,一張高清圖片可能就有好幾兆的數(shù)據(jù),一個模型要處理成千上萬張這樣的圖片,那延遲自然就上去了。

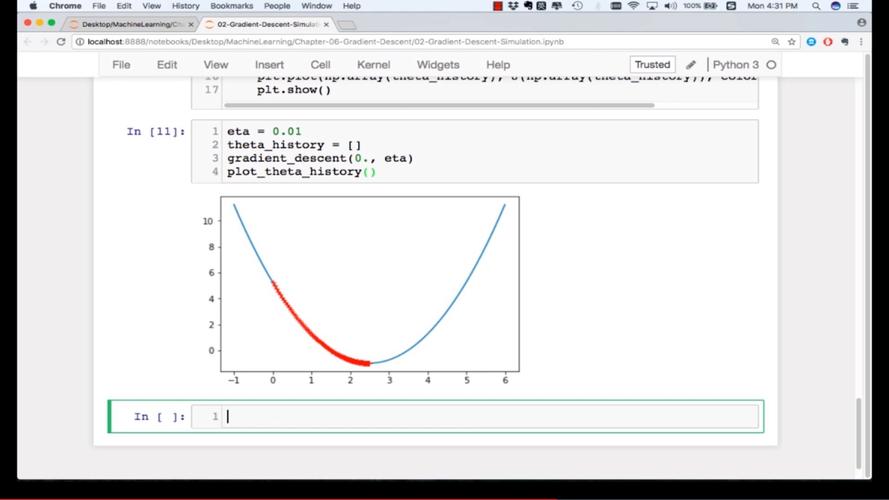

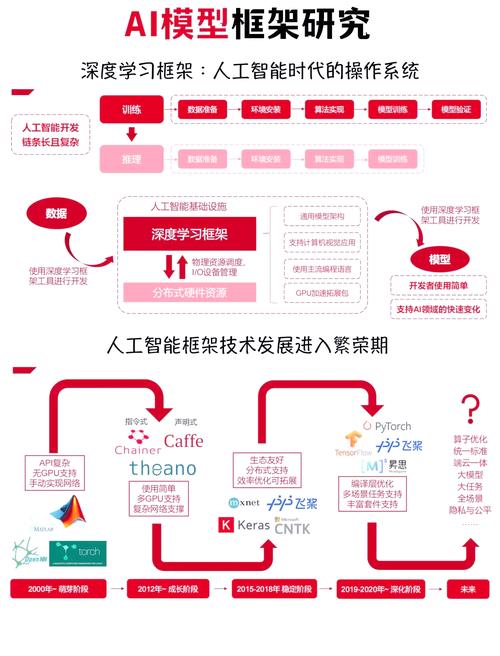

模型復(fù)雜度高也是個因素,現(xiàn)在的AI模型越來越復(fù)雜,就像一座迷宮,里面有很多彎彎繞繞,模型越復(fù)雜,計算量就越大,處理時間也就越長,比如說,一些深度學(xué)習(xí)模型,有好幾層神經(jīng)網(wǎng)絡(luò),每層都有大量的參數(shù)需要計算,這就會導(dǎo)致延遲增加。

還有硬件性能,AI模型運(yùn)行得靠硬件支持,要是硬件性能不行,那就像一輛破車,跑不起來,比如說,你用一臺老舊的電腦去運(yùn)行一個大型的AI模型,那速度肯定快不了,延遲也就高了。

網(wǎng)絡(luò)狀況也會影響AI模型延遲,要是你在用云端的AI服務(wù),網(wǎng)絡(luò)不好,數(shù)據(jù)傳輸就慢,AI模型接收數(shù)據(jù)和處理結(jié)果的時間就會變長,就好比你在網(wǎng)上下載一個大文件,網(wǎng)速慢,下載時間就長,道理是一樣的。

AI模型延遲帶來的麻煩

AI模型延遲帶來的麻煩可不少。

在用戶體驗方面,那簡直就是災(zāi)難,就像前面說的玩游戲和用智能語音助手,延遲高了,用戶肯定不滿意,在一些對實(shí)時性要求很高的場景,比如自動駕駛,AI模型延遲可能會帶來嚴(yán)重的安全問題,想象一下,一輛自動駕駛汽車在遇到危險時,因為AI模型延遲,不能及時做出反應(yīng),那后果不堪設(shè)想。

在業(yè)務(wù)運(yùn)營方面,AI模型延遲也會影響效率,比如說,一家電商公司用AI模型來推薦商品,要是模型延遲高,用戶打開頁面半天看不到推薦結(jié)果,可能就會流失,在一些金融交易場景,延遲可能會導(dǎo)致錯過最佳交易時機(jī),造成經(jīng)濟(jì)損失。

咋解決AI模型延遲問題?

既然AI模型延遲這么麻煩,那咱得想辦法解決啊。

從數(shù)據(jù)方面來說,可以對數(shù)據(jù)進(jìn)行預(yù)處理,比如說,對圖像進(jìn)行壓縮,減少數(shù)據(jù)量,這樣AI模型處理起來就快了,還可以采用數(shù)據(jù)緩存技術(shù),把經(jīng)常用的數(shù)據(jù)緩存起來,下次用的時候直接調(diào)用,不用重新處理,也能減少延遲。

在模型優(yōu)化方面,可以簡化模型結(jié)構(gòu),就像把一座復(fù)雜的迷宮簡化成一條直路,這樣AI模型就能更快地找到結(jié)果,還可以采用模型壓縮技術(shù),把模型的大小減小,減少計算量,使用更高效的算法也能提高模型的運(yùn)行速度,降低延遲。

硬件升級也是個辦法,要是你的硬件性能不行,那就換一臺性能好的,比如說,用專業(yè)的AI服務(wù)器,或者GPU加速卡,這些硬件都能大大提高AI模型的處理速度。

在網(wǎng)絡(luò)方面,可以采用更穩(wěn)定的網(wǎng)絡(luò)連接,比如說,使用專線網(wǎng)絡(luò),避免網(wǎng)絡(luò)擁堵,還可以采用邊緣計算技術(shù),把AI模型部署在離用戶更近的地方,減少數(shù)據(jù)傳輸?shù)臅r間,降低延遲。

實(shí)際案例說說看

咱來舉幾個實(shí)際例子,看看AI模型延遲是咋影響業(yè)務(wù),又是咋解決的。

有個在線教育平臺,用AI模型來給學(xué)生推薦課程,一開始,他們發(fā)現(xiàn)推薦結(jié)果出來得很慢,學(xué)生體驗很差,后來他們分析發(fā)現(xiàn),是因為數(shù)據(jù)量太大,模型處理不過來,他們對數(shù)據(jù)進(jìn)行了預(yù)處理,把一些不重要的信息去掉,還采用了數(shù)據(jù)緩存技術(shù),他們對模型進(jìn)行了優(yōu)化,簡化了模型結(jié)構(gòu),經(jīng)過這些改進(jìn),推薦結(jié)果的延遲大大降低,學(xué)生滿意度也提高了。

還有一個智能安防企業(yè),用AI模型來進(jìn)行人臉識別,在一些大型活動現(xiàn)場,由于人流量大,數(shù)據(jù)量激增,AI模型延遲很高,導(dǎo)致識別準(zhǔn)確率下降,他們采用了邊緣計算技術(shù),把AI模型部署在現(xiàn)場的設(shè)備上,減少了數(shù)據(jù)傳輸?shù)皆贫说臅r間,他們對硬件進(jìn)行了升級,使用了高性能的GPU加速卡,這樣一來,人臉識別的速度大大提高,延遲也降低了,活動現(xiàn)場的安全保障得到了有效提升。

隨著AI技術(shù)的不斷發(fā)展,AI模型延遲問題肯定會越來越受到重視,可能會有更多先進(jìn)的技術(shù)來解決這個問題。

比如說,量子計算技術(shù)的發(fā)展可能會給AI模型帶來質(zhì)的飛躍,量子計算機(jī)的計算速度比傳統(tǒng)計算機(jī)快得多,要是能用量子計算機(jī)來運(yùn)行AI模型,那延遲肯定會大大降低。

新的算法和模型架構(gòu)也會不斷涌現(xiàn),研究人員會不斷探索更高效的算法,優(yōu)化模型結(jié)構(gòu),讓AI模型在更短的時間內(nèi)處理更多的數(shù)據(jù)。

隨著5G等高速網(wǎng)絡(luò)的普及,網(wǎng)絡(luò)狀況也會越來越好,這也有助于降低AI模型延遲。

好了,朋友們,今天咱們聊了這么多關(guān)于AI模型延遲的事兒,AI模型延遲雖然是個讓人頭疼的問題,但也不是沒辦法解決,咱們可以從數(shù)據(jù)、模型、硬件、網(wǎng)絡(luò)等方面入手,采取各種措施來降低延遲,相信在未來,隨著技術(shù)的不斷進(jìn)步,AI模型延遲問題會得到更好的解決,AI技術(shù)也會給我們帶來更好的體驗,咱們就拭目以待吧!

還沒有評論,來說兩句吧...