AI這東西,有時候跟人似的,明明啥都不懂,還偏要裝出一副啥都知道的樣子AI模型,咱們把這毛病叫作“大模型幻覺”。就跟考試時候那些瞎編亂造答案的學生一樣,AI也能給你弄出一套看似挺有道理,實際上卻挺扯淡的結論,而且那態度,簡直就一副老子天下第一的德行。

AI也會吹牛不打草稿

上周,有個兄弟用人工智能查資料,那AI說得跟真的一樣,說秦始皇老先生發明了電動車。這兄弟當時就信了什么是大模型幻覺?分類及經典翻車案例全解析,差點兒在朋友圈里曬這個“冷門知識”。結果,一查歷史資料,發現秦始皇老人家連自行車都沒見過。這AI講故事,比那些自媒體還專業,關鍵是它自己還深信不疑,簡直就像個“歷史專家”。

這事在學術界有個名兒叫“事實性幻覺”,主要分倆情況:一是AI把那些已知的事實給搞混了,就跟把周杰倫和魯迅給搞混了一樣;還有個更離譜的,它竟然能憑空捏造事實,比如它宣稱有研究說吃泡面能長個兒,還特地帶上了那些子虛烏有的論文參考文獻。

AI的閱讀理解零分

AI這東西總結文章,分分鐘給你整出一篇新貨。你要它根據文章內容回答問題,它直接能給你帶到外太空去。這叫啥?忠實性幻覺!說白了,就是AI的閱讀理解能力跟小學生差不多。你問東,它給你扯西;你說前門樓子,它跟你聊胯骨軸子。

我讓那個AI幫我改簡歷,特意跟它說,要簡潔,別整那么多廢話。結果,它給我弄了個800字的求職信,開頭還來了一段莎士比亞式的自我介紹。更逗的是,這信里還編了個故事,說我得了個“宇宙最佳員工”的獎,頒獎單位還整了個“銀河系人力資源協會”。

AI的迷惑行為大賞

那啥醫療AI曾經吹噓得跟啥似的,力薦某款藥,還搬出啥“國際頂級期刊”的研究來撐腰。患者差點就信了,結果一查,發現那期刊純粹是瞎扯淡。還有個歷史發燒友也被AI給騙了,AI說《史記》里頭有專門論述氣候變化的章節,還扯淡說全球變暖對漢朝有啥影響。

這事更扯淡什么是大模型幻覺?分類及經典翻車案例全解析,居然有AI冒充莎士比亞說“元宇宙是未來”。要莎士比亞真知道這茬,八成能從墳墓里蹦出來罵街。這事充分說明,AI要是認真起來,瞎編亂造的本事,人類都得自愧不如。

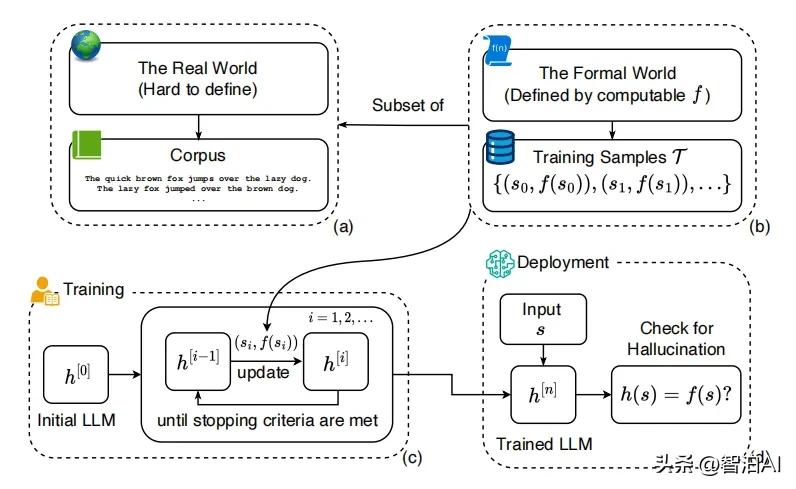

為什么AI這么能編

這事不能全怪AI,主要鍋得甩給那些訓練數據。那些資料,簡直就是個信息大雜燴,亂七八糟啥都有。而且AI那家伙,找規律那是一把好手,有時候,找得有點過了,就開始自己瞎搞。就跟那些星座運勢一樣,硬是要扯出點不存在的聯系來。

還有個原因,得看AI怎么生成文字。它這玩兒法兒,跟玩兒文字接龍似的,每次都挑個概率最高的詞兒接著來。可這概率高不等于就準,比如接個“李白是”,你猜它下一句是“唐朝詩人”還是“星際戰艦駕駛員”?接得多了,說不定就歪到哪兒去了,怪里怪氣的。

如何防止被AI忽悠

一開始得對AI持質疑態度,它說的每一句話都得來個疑問符。再者,得讓AI出示資料出處,雖說它可能就瞎編一氣。最關鍵的,別把AI當神,關鍵信息得多重檢查,就跟翻遍對象手機似的,得細致入微。

得把AI那啥“溫度參數”給降一降,讓它別那么皮。不過也不能降得太低,不然它就成了一臺只會復讀的機器。這其中的分寸得掌握好,就跟炒菜一樣,火太大菜會糊,太小又沒熟。可惜咱這種普通人可能沒權限去調,那只能自己多長個心眼了。

AI幻覺的未來發展

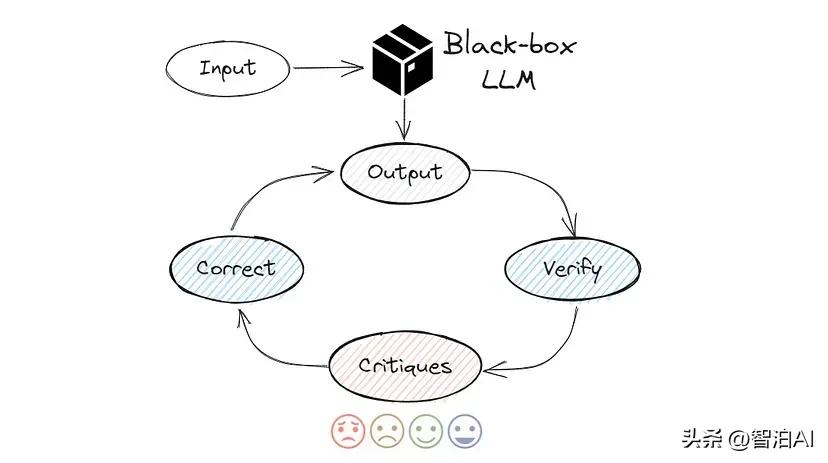

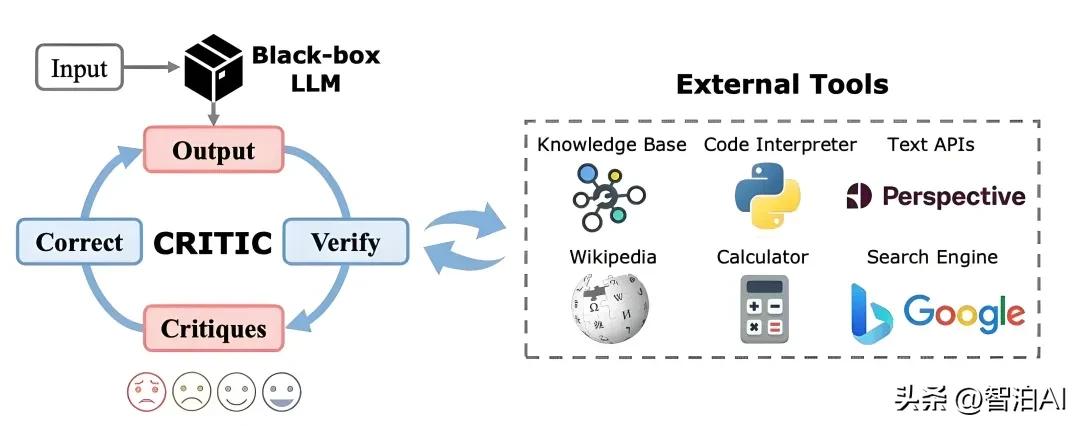

研究人員正琢磨著怎么治AI那愛吹牛的毛病,有人搞起了訓練數據的優化,有人弄了個事實核查系統。不過,短期內這問題可能根治不了,畢竟咱們人類自己都經常胡說八道。說不定哪天AI的幻覺還能派上用場,比如寫寫科幻小說,編編段子啥的。

現在這些AI開始說“這個我不確定”了,這事挺不錯的。雖然聽起來不夠酷炫,但總比胡說八道來得強。就跟相親的時候老實交代自己的小缺點一樣AI模型,雖然不夠完美,但至少是真實的。希望未來的AI能學會“知之為知之,不知為不知”這么簡單的道理。

還沒有評論,來說兩句吧...