AI模型響應速度:快與慢的微妙博弈,到底多重要?

嘿,朋友們,今天咱們來聊聊AI模型響應速度這個事兒,說實話,這看似不起眼的小細節,背后可藏著大學問呢!

想象一下,你正忙著處理一堆數據,或者是在線等著AI給你出個主意,結果它慢悠悠地,半天才給你回個話,是不是讓人急得直跺腳?這AI模型的響應速度啊,就像是咱們生活中的快遞小哥,快則讓人滿心歡喜,慢則讓人心生不滿。

先說說快的好處吧,就拿我親身經歷的一件事兒來說,之前我負責的一個項目,需要用到AI模型來做數據分析,那時候,我們選了一個響應速度超快的模型,幾乎是秒回,每次我輸入問題,它立馬就能給出答案,而且準確率還挺高,這效率,簡直了!項目進展得那叫一個順利,團隊里的每個人都對它贊不絕口,因為響應速度快,我們節省了大量時間,可以把更多精力放在其他關鍵環節上,整個項目的周期都縮短了不少。

再舉個例子,現在很多智能客服系統都用上了AI模型,要是響應速度快,用戶一問問題,立馬就能得到回復,那用戶體驗肯定好啊,用戶會覺得這平臺靠譜、專業,下次還愿意來,相反,如果響應速度慢,用戶等得不耐煩了,可能就直接關掉頁面,另尋他家了,這流失的可都是潛在客戶啊!

那慢的AI模型響應速度會帶來啥問題呢?除了上面提到的用戶體驗差,還會影響工作效率,比如在一些需要實時決策的場景中,像金融交易、自動駕駛這些,AI模型的響應速度直接關系到決策的及時性和準確性,要是響應慢了,可能就會導致錯過最佳交易時機,或者自動駕駛車輛出現危險情況,這可不是鬧著玩的,后果可能非常嚴重。

而且啊,慢的響應速度還可能增加成本,就拿云計算來說,AI模型運行需要消耗計算資源,響應速度慢,就意味著模型運行時間長,消耗的資源就多,成本自然就上去了,對于企業來說,這可是一筆不小的開支。

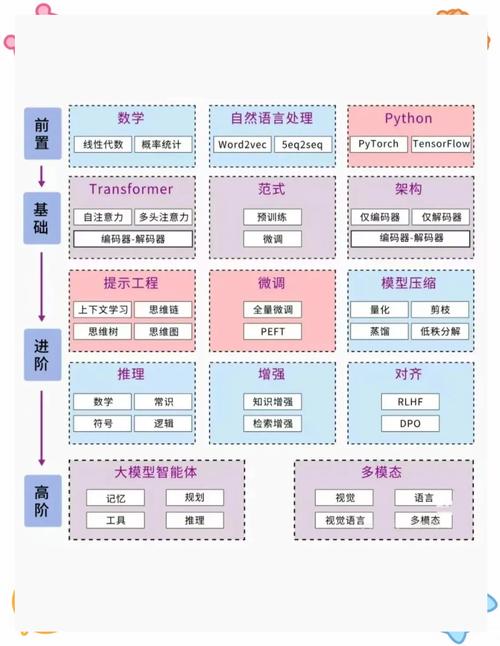

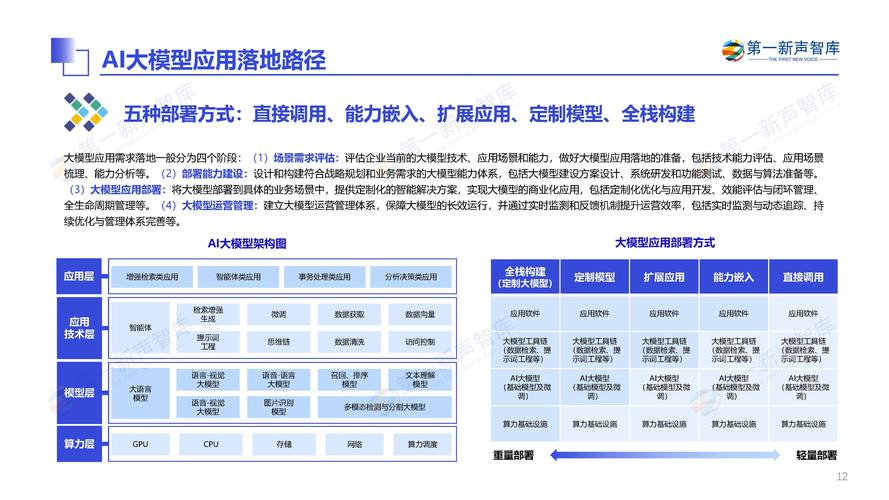

那怎么才能提高AI模型的響應速度呢?這方法可不少,可以從模型本身入手,優化算法,減少計算量,比如說,采用更高效的神經網絡結構,或者對模型進行剪枝、量化等操作,讓模型變得更“輕盈”,運行起來自然就快了,還可以從硬件方面著手,使用更強大的計算設備,比如GPU、TPU這些,它們的計算能力可比普通的CPU強多了,能大大縮短模型的響應時間。

數據存儲和傳輸的速度也會影響AI模型的響應速度,如果數據存儲在一個很慢的硬盤上,或者數據傳輸的網絡帶寬很小,那模型讀取數據和處理數據的時間就會變長,采用高速的存儲設備和大帶寬的網絡,也是提高響應速度的有效方法。

啊,AI模型響應速度這事兒,看似簡單,實則復雜,它關系到用戶體驗、工作效率、成本等多個方面,無論是企業還是個人,在選擇和使用AI模型的時候,都不能忽視這個重要因素,只有讓AI模型響應速度快起來,咱們才能更好地享受AI帶來的便利和高效,怎么樣,朋友們,是不是對AI模型響應速度有了更深的認識呢?

還沒有評論,來說兩句吧...