AI模型可解釋性:打開黑箱,讓智能更透明

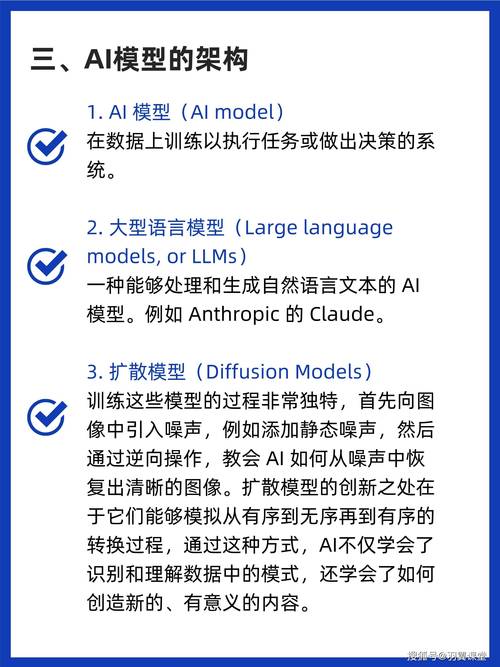

現在這年頭,AI(人工智能)已經滲透到咱們生活的方方面面了,從手機里的語音助手,到網上購物時的推薦系統,再到醫療診斷、自動駕駛,AI無處不在,但你有沒有想過,這些看似無所不能的AI模型,它們到底是怎么做出決策的呢?這就引出了一個重要的話題——AI模型的可解釋性。

咱們先說說啥是AI模型的可解釋性,就是讓AI模型的決策過程變得透明,讓人能理解它為啥會這么選,你想啊,如果AI在醫療上給病人開藥,或者自動駕駛汽車在關鍵時刻做決定,咱們總得知道它為啥這么干吧?不然心里多沒底啊!

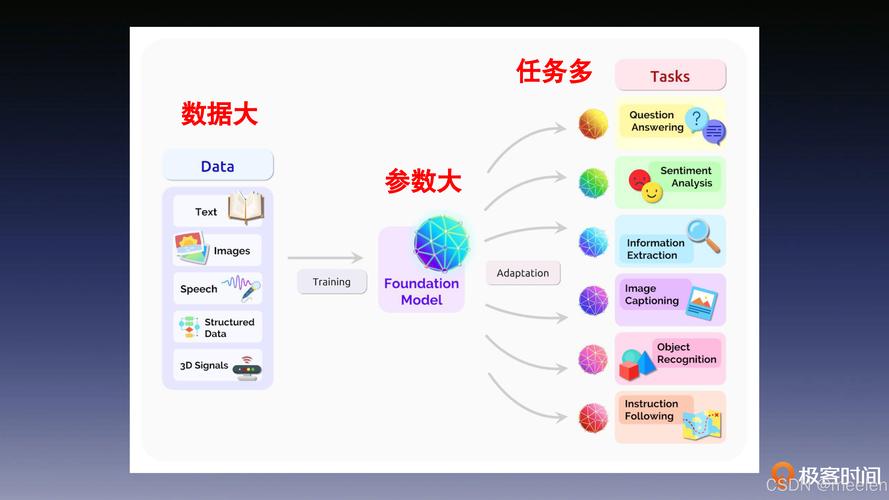

以前,很多AI模型,特別是深度學習模型,就像是個黑箱,你給它輸入數據,它給你輸出結果,但中間的過程,嘿,那是一點兒都不透露,這就好比你去飯店吃飯,廚師直接給你端上來一盤菜,你問這菜咋做的,廚師說:“秘密,別問!”你吃得心里能踏實嗎?

但現在,情況不一樣了,隨著AI技術的不斷發展,大家越來越意識到可解釋性的重要性,科學家們開始研究各種方法,來打開這個黑箱,讓AI模型的決策過程變得可理解。

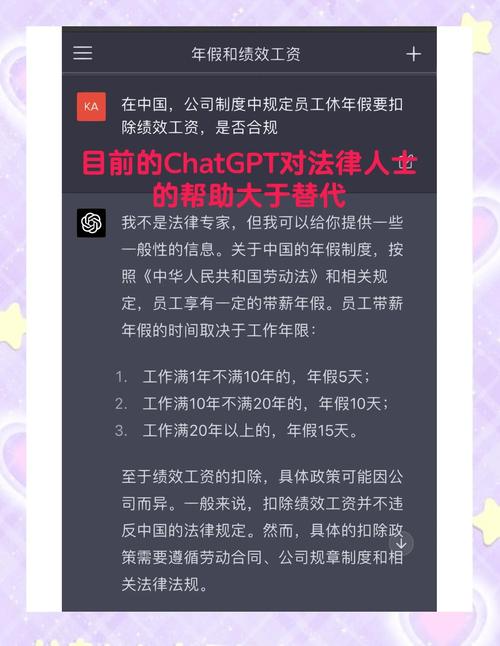

舉個例子吧,有個研究團隊開發了一種新的AI模型,專門用來預測心臟病風險,這個模型不僅準確率高,而且還能告訴你,它為啥覺得你有心臟病風險,它會說:“根據您的年齡、血壓、膽固醇水平,以及家族病史,我們認為您有較高的心臟病風險。”這樣一來,醫生就能根據這些信息,給你制定更個性化的治療方案了。

再來說說自動駕駛,自動駕駛汽車得在各種復雜情況下做出快速決策,比如突然有行人橫穿馬路,或者前方車輛急剎車,如果AI模型不可解釋,那出了事故,咱們怎么判斷是誰的責任呢?但現在,有了可解釋性的AI模型,它就能告訴你:“在那一刻,我檢測到了前方有障礙物,根據我的算法,我選擇了剎車來避免碰撞。”這樣一來,事故責任就清晰多了。

要讓AI模型變得可解釋,也不是那么容易的事兒,科學家們得研究各種算法,還得考慮模型的復雜性和準確性之間的平衡,為了讓模型更可解釋,可能就得犧牲一點準確性;但反過來,如果只追求準確性,模型就可能變得像黑箱一樣難以理解。

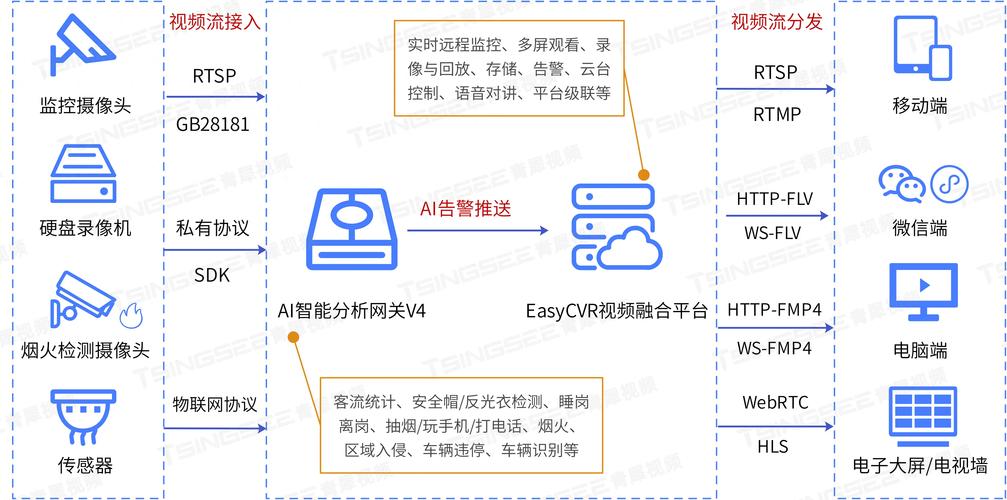

好在現在已經有不少進展了,有些研究團隊通過可視化技術,把AI模型的決策過程展示出來,讓人一看就懂,還有些團隊,開發了專門的工具,來分析AI模型的決策邏輯,找出影響決策的關鍵因素。

AI模型的可解釋性是AI技術發展的一個重要方向,它不僅能讓咱們更放心地使用AI,還能推動AI技術在更多領域的應用,畢竟,誰不想用個既聰明又透明的AI助手呢?

所以啊,咱們得繼續關注這個話題,看看科學家們還能想出啥新招兒,來讓AI模型變得更可解釋,說不定哪天,咱們就能完全理解AI的每一個決策,讓AI真正成為咱們生活中的得力助手了。