想擁有更安心、流暢的AI交互體驗嗎?我們的AI模型風險控制系統,從用戶體驗出發,精準把控風險,為您打造安全無憂、高效便捷的AI使用新境界!

AI模型風險控制系統:構建智能時代的穩健基石

在當今這個數據驅動、算法主導的時代,人工智能(AI)技術正以前所未有的速度滲透到社會經濟的各個角落,從金融交易、醫療診斷到自動駕駛、智能制造,AI模型的應用極大地提升了效率與精準度,隨著AI技術的廣泛應用,其潛在的風險也日益凸顯,包括但不限于算法偏見、數據泄露、模型誤判等,這些風險不僅可能損害個人權益,還可能對社會的穩定與發展構成威脅,構建一套高效、全面的AI模型風險控制系統,成為保障AI技術健康、可持續發展的關鍵。

AI模型風險概述

AI模型風險,簡而言之,是指由于AI系統在設計、訓練、部署及使用過程中存在的缺陷或不當操作,導致的不良后果或潛在威脅,這些風險大致可以分為以下幾類:

- 算法偏見:由于訓練數據的不均衡或算法設計上的缺陷,AI模型可能對特定群體產生不公平的判斷,如性別、種族、年齡等偏見,這在招聘、信貸審批等領域尤為敏感。

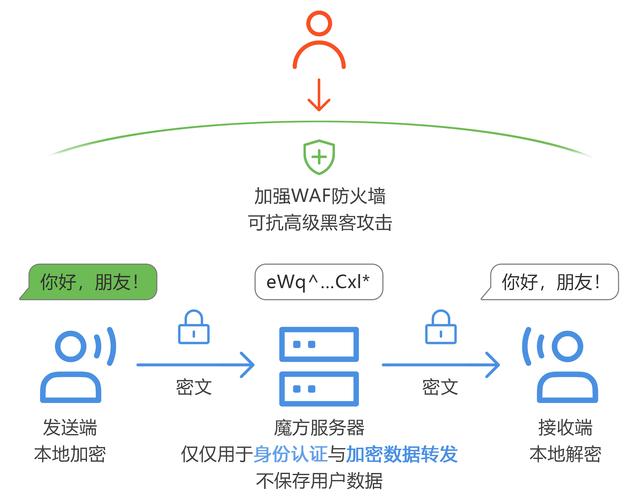

- 數據安全與隱私泄露:AI模型依賴大量數據進行訓練,數據的收集、存儲、處理過程中若缺乏有效的安全措施,極易導致用戶隱私泄露,甚至被惡意利用。

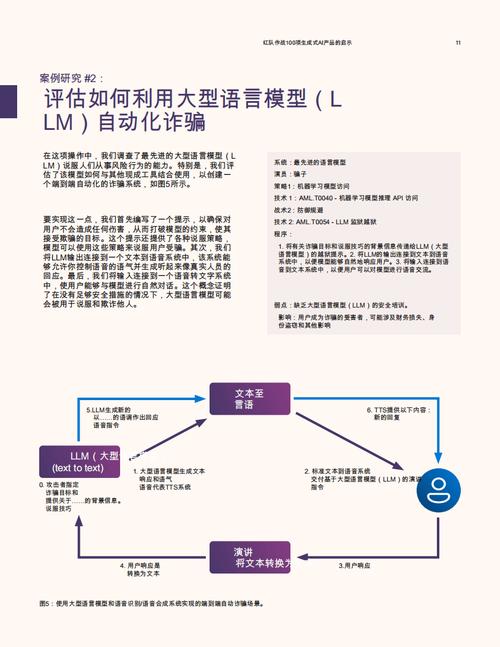

- 模型誤判與決策失誤:在復雜多變的現實環境中,AI模型可能因訓練數據不足、環境變化或算法局限性而做出錯誤判斷,影響決策的準確性和可靠性。

- 倫理與法律風險:AI技術的應用往往涉及倫理道德和法律法規的邊界,如自動駕駛中的責任歸屬、AI生成內容的版權問題等,需要明確的法律框架和倫理指導。

AI模型風險控制系統的構建

面對上述風險,構建一套科學、系統的AI模型風險控制系統顯得尤為重要,該系統應涵蓋風險識別、評估、監控、應對及持續改進等多個環節,形成閉環管理。

風險識別與評估

- 數據審計:對訓練數據進行全面審計,確保數據的多樣性、代表性和合法性,識別并糾正數據中的偏見和錯誤。

- 算法透明度:提高AI模型的透明度,通過可解釋性技術(如LIME、SHAP等)揭示模型決策過程,便于發現潛在風險點。

- 風險評估模型:建立風險評估模型,綜合考慮技術、法律、倫理等多維度因素,對AI模型的風險等級進行量化評估。

風險監控與預警

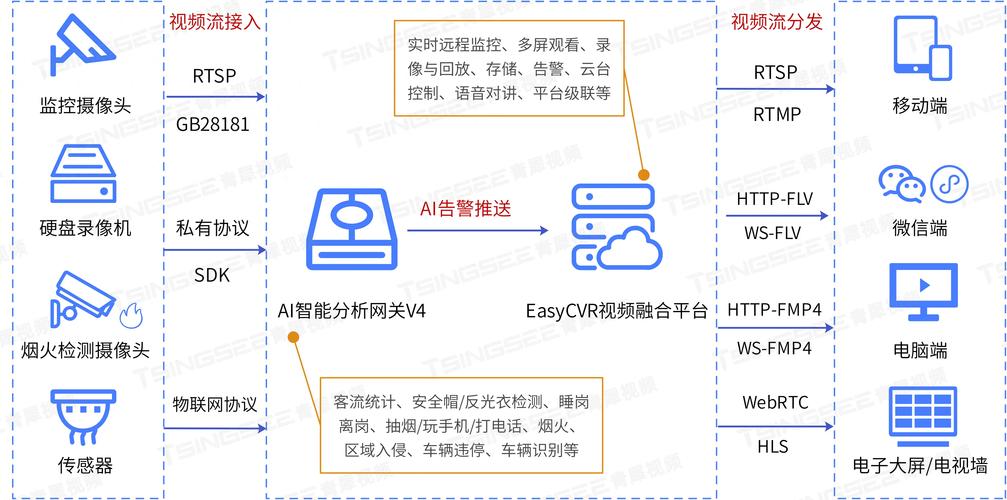

- 實時監控:部署實時監控系統,對AI模型的運行狀態、輸入輸出數據進行持續監測,及時發現異常行為。

- 預警機制:設定風險閾值,當監控指標超出正常范圍時,自動觸發預警,通知相關人員采取措施。

- 日志記錄與審計追蹤:詳細記錄AI模型的操作日志,便于事后審計和問題追溯。

風險應對與處置

- 應急預案:制定詳細的應急預案,明確不同風險等級下的應對措施,包括模型調整、數據修正、法律咨詢等。

- 多方協作:建立跨部門、跨領域的協作機制,確保在風險發生時能夠迅速響應,有效處置。

- 用戶反饋與投訴處理:建立用戶反饋渠道,及時收集用戶對AI模型使用的意見和建議,對投訴進行快速響應和處理。

持續改進與優化

- 定期復審:定期對AI模型進行復審,評估其性能、風險狀況及合規性,根據評估結果進行調整和優化。

- 技術創新:關注AI技術的最新進展,引入新技術、新方法,不斷提升風險控制系統的效能。

- 教育與培訓:加強對AI開發者和使用者的教育與培訓,提高其風險意識和應對能力。

AI模型風險控制系統的挑戰與展望

盡管AI模型風險控制系統的構建具有重要意義,但在實際操作中仍面臨諸多挑戰,如技術實現的復雜性、法律法規的滯后性、公眾認知的局限性等,隨著技術的不斷進步和社會的廣泛參與,我們有理由相信,AI模型風險控制系統將更加完善,為AI技術的健康發展提供堅實保障。

- 技術創新:隨著深度學習、強化學習等技術的不斷發展,AI模型的復雜性和智能性將進一步提升,風險控制技術也需不斷創新,以適應新的挑戰。

- 法律法規完善:各國政府應加快制定和完善AI相關的法律法規,明確AI技術的使用邊界和責任歸屬,為風險控制提供法律支撐。

- 公眾參與與監督:鼓勵公眾參與AI技術的討論和監督,提高社會對AI風險的認知度,形成全社會共同參與的風險防控格局。

AI模型風險控制系統是保障AI技術健康、可持續發展的關鍵,通過構建科學、系統的風險控制體系,我們不僅能夠有效應對AI技術帶來的風險,還能促進AI技術的創新與應用,為人類社會的進步貢獻力量。

還沒有評論,來說兩句吧...