想深入了解AI模型測試背后的系統配置奧秘嗎?本文將為你揭秘系統配置的關鍵要點,助你優化測試流程,提升AI模型性能,不容錯過!

AI模型測試那些事兒:從入門到實戰的避坑指南

最近跟幾個做AI的朋友聊天,發現大家對模型測試這事兒特別上頭,有人吐槽測試數據集像開盲盒,有人抱怨測試結果總跟預期差口氣,作為一個在AI行業摸爬滾打三年的測試工程師,今天就跟大家嘮嘮AI模型測試的門道,全是實戰中踩過的坑和總結的經驗。

先說個真實案例,去年我們團隊給某電商公司做商品推薦模型,上線前測試指標都挺漂亮,結果上線后用戶反饋"推薦的東西完全不搭邊",后來復盤發現,測試數據集里80%都是熱門商品,冷門商品覆蓋率不到5%,導致模型對長尾商品的理解嚴重跑偏,這個教訓告訴我們:測試數據集的質量直接決定模型生死。

那怎么構建靠譜的測試數據集呢?我的經驗是分三步走: 第一步是數據清洗,去年我們處理某金融風控模型時,發現原始數據里居然有15%的異常值,這些"臟數據"差點讓模型學歪了,現在每次測試前,我都會用3σ原則和箱線圖法做兩輪清洗。 第二步是分層采樣,就像做蛋糕要按比例放材料,測試集也要按業務場景分層,比如圖像分類模型,要保證每類樣本數量誤差不超過5%,去年有個項目就因為類別失衡,把貓狗分類做成了"只要是毛茸茸都算狗"。 第三步是動態更新,現在業務變化快,測試集也要跟著迭代,我們團隊每月都會根據用戶行為日志更新20%的測試數據,就像給模型定期做體檢。

測試指標的選擇更是個技術活,很多人盯著準確率不放,其實這就像只看考試成績不看偏科情況,去年做OCR識別項目時,我們發現模型在印刷體上的準確率高達99%,但手寫體只有70%,后來引入了F1-score和混淆矩陣,才發現模型對手寫連筆的識別能力嚴重不足,現在我們的測試報告至少包含5個核心指標:準確率、召回率、F1值、ROC曲線和AUC值,就像給模型做全面體檢。

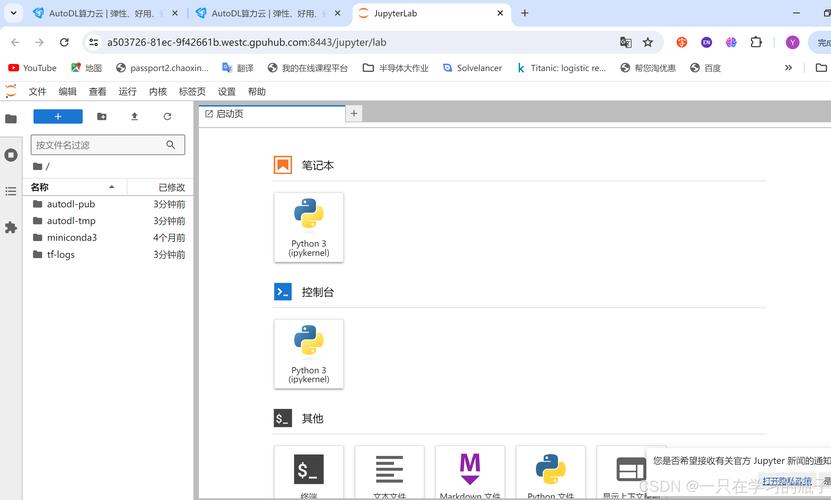

測試環境搭建也有講究,記得第一次做NLP模型測試時,我們在本地環境跑得好好的,上線后卻因為GPU版本差異導致性能下降30%,現在我們的測試環境必須滿足三個條件:硬件配置與生產環境一致、軟件版本完全對齊、數據分布完全模擬真實場景,就像做菜要控制火候,測試環境也要精準把控。

自動化測試工具的選擇也很關鍵,我們團隊現在用PyTest+Allure的組合,前者負責測試用例管理,后者生成可視化報告,上個月通過自動化測試提前發現了模型在特定輸入下的崩潰問題,避免了可能的價值百萬的線上事故,不過工具只是輔助,關鍵是要建立完整的測試流程:單元測試→集成測試→系統測試→回歸測試,就像給模型上四道保險。

最后說說測試報告的撰寫,很多人覺得把數據堆上去就行,其實好的報告要像講故事,上個月我們給某醫療AI項目寫的報告,不僅包含各項指標,還專門分析了誤診案例的共性特征,幫助研發團隊快速定位問題,測試報告不是給機器看的,是給人看的。

現在AI模型測試已經不是簡單的"跑數據",而是需要系統化的工程能力,從數據準備到指標選擇,從環境搭建到報告撰寫,每個環節都藏著學問,建議大家建立自己的測試知識庫,我們團隊就整理了200多個常見測試場景和解決方案,遇到問題直接查庫,效率提升50%以上。

AI模型測試就像給智能系統做體檢,既要全面細致,又要抓住關鍵,希望今天的分享能給大家一些啟發,畢竟在AI這條路上,測試就是那道守護質量的最后防線,下次遇到測試難題,不妨想想今天說的這些方法,說不定就能找到突破口。

還沒有評論,來說兩句吧...