人工智能的大型模型正以其非凡的能力掀起了一場(chǎng)科技變革的浪潮,引發(fā)了眾人的驚嘆與探索欲望。那么,這個(gè)模型究竟是什么樣的?它的成長(zhǎng)歷程和應(yīng)用范圍又是怎樣的?讓我們跟隨本文,共同揭開(kāi)它神秘的面紗。

# 典型模型參數(shù)對(duì)比(2023)

models = {

"GPT-3": 175*10**9,

"PaLM-2": 340*10**9,

"LLaMA-2": 70*10**9

}

技術(shù)定義:重新理解AI大模型

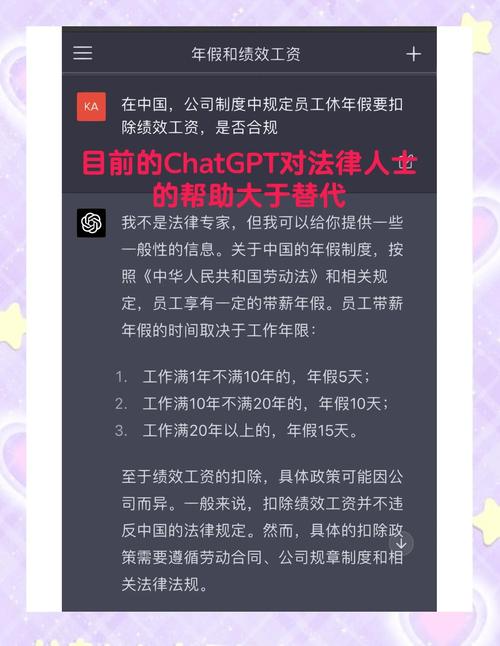

AI的大型模型是指那些參數(shù)數(shù)量超過(guò)十億的深度學(xué)習(xí)模型。這樣的模型在參數(shù)數(shù)量上比傳統(tǒng)模型有了三到五個(gè)數(shù)量級(jí)的飛躍,這無(wú)疑是一個(gè)顯著的進(jìn)步。傳統(tǒng)模型的參數(shù)通常只有百萬(wàn)級(jí)別,而大型模型卻能擁有數(shù)十億甚至更多的參數(shù)。此外,它們的上下文學(xué)習(xí)能力同樣令人稱(chēng)奇什么是AI大模型?從入門(mén)到精通,一篇文章全搞定,它們無(wú)需經(jīng)過(guò)細(xì)致調(diào)整就能應(yīng)對(duì)新的挑戰(zhàn)。比如,GPT-3的Few-Shot功能,就充分展現(xiàn)了它在面對(duì)未知任務(wù)時(shí)的出色適應(yīng)能力。

多模態(tài)融合是一項(xiàng)至關(guān)重要的技術(shù)進(jìn)展。CLIP技術(shù)成功實(shí)現(xiàn)了圖像與文字之間的跨模態(tài)認(rèn)知,比如,它能識(shí)別出圖片和文字之間的關(guān)聯(lián),在搜索時(shí),只需輸入文字就能精確匹配到相應(yīng)的圖片,這極大地?cái)U(kuò)展了其應(yīng)用范圍。

發(fā)展脈絡(luò):十年演進(jìn)關(guān)鍵節(jié)點(diǎn)

模型效果 ∝ 參數(shù)規(guī)模 × 數(shù)據(jù)量 × 計(jì)算量

時(shí)間記錄了大型模型成長(zhǎng)的腳步。起初,若干關(guān)鍵節(jié)點(diǎn)事件彰顯了生成式人工智能的巨大潛力,使人們開(kāi)始意識(shí)到大模型在內(nèi)容創(chuàng)作方面的廣闊應(yīng)用前景。接著,開(kāi)源的圖像生成模型變得廣泛流行,使得眾多開(kāi)發(fā)者和企業(yè)能夠運(yùn)用并改進(jìn)相關(guān)技術(shù),進(jìn)而加速了圖像生成領(lǐng)域的快速發(fā)展。

以一個(gè)具體的開(kāi)源項(xiàng)目為例,這樣的項(xiàng)目降低了技術(shù)門(mén)檻,讓即便是小型企業(yè)也能借助開(kāi)源模式開(kāi)展圖像創(chuàng)作,進(jìn)而推動(dòng)了行業(yè)的多元化進(jìn)程。隨著時(shí)間的推移,在多個(gè)關(guān)鍵轉(zhuǎn)折時(shí)刻,大型模型不斷取得進(jìn)展,其功能也在不斷增多。

# 典型訓(xùn)練成本(以70B模型為例)

├── 硬件成本:約$2,000,000

├── 數(shù)據(jù)成本:300TB文本數(shù)據(jù)

└── 能耗成本:≈500戶(hù)家庭年用電量

核心特征解析:技術(shù)DNA拆解

參數(shù)規(guī)模定律是大型模型的核心特征。當(dāng)參數(shù)數(shù)量上升時(shí),模型在學(xué)習(xí)和表達(dá)上的能力也會(huì)相應(yīng)提升,這使得它能夠識(shí)別出更加復(fù)雜的數(shù)據(jù)特征。以自然語(yǔ)言處理領(lǐng)域?yàn)槔瑓?shù)的增多有助于更深刻地把握語(yǔ)義和語(yǔ)境,進(jìn)而使得生成的文本看起來(lái)更加自然和順滑。

# 使用HuggingFace加載LLaMA2

from transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-2-7b-chat-hf",

device_map="auto"

)

關(guān)鍵技術(shù)組件不容忽視。這些組件是大型模型運(yùn)行的基礎(chǔ),它們包括從數(shù)據(jù)處理到算法優(yōu)化的各個(gè)步驟,各部分相互協(xié)作,確保了模型的順暢運(yùn)行。眾多研究機(jī)構(gòu)投入了大量資源,專(zhuān)注于對(duì)這些建構(gòu)塊進(jìn)行改進(jìn),以期提升大模型的性能。

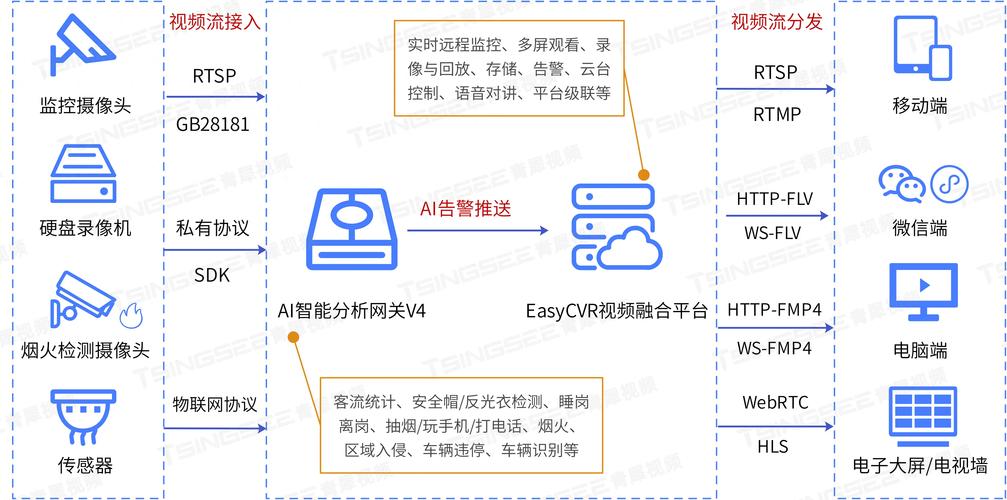

產(chǎn)業(yè)落地全景圖

大模型在多個(gè)關(guān)鍵應(yīng)用場(chǎng)景中表現(xiàn)出色。在醫(yī)療領(lǐng)域,它通過(guò)學(xué)習(xí)海量的病例數(shù)據(jù),助力醫(yī)生作出疾病診斷,極大地提高了診斷的準(zhǔn)確性。此外,在金融行業(yè),它還能進(jìn)行風(fēng)險(xiǎn)評(píng)價(jià)和投資趨勢(shì)的預(yù)測(cè),為投資者提供了更為科學(xué)的決策依據(jù)。

+ 掌握分布式訓(xùn)練技術(shù)

+ 深入理解Transformer架構(gòu)

- 避免盲目追求參數(shù)量

以某醫(yī)療公司為例,引入了大規(guī)模模型之后,其診斷錯(cuò)誤率大幅降低。在金融行業(yè),一些投資公司運(yùn)用大規(guī)模模型制定的策略,成功獲得了更高的投資回報(bào),這充分體現(xiàn)了大規(guī)模模型在產(chǎn)業(yè)中的應(yīng)用價(jià)值。

實(shí)戰(zhàn)指南:從零構(gòu)建大模型

打造大型模型需要依托于完善的開(kāi)發(fā)工具鏈。框架的挑選至關(guān)重要,必須考慮到個(gè)人或團(tuán)隊(duì)的技術(shù)條件和實(shí)際需求。在訓(xùn)練過(guò)程中,運(yùn)用A100集群可以顯著縮短訓(xùn)練周期。對(duì)于模型壓縮,我們采納了知識(shí)蒸餾方法,以此在不明顯影響性能的情況下,縮小模型體積。此外,部署工具確保了模型能在各種環(huán)境中穩(wěn)定執(zhí)行。

開(kāi)發(fā)者通過(guò)關(guān)鍵代碼實(shí)例獲取實(shí)踐操作的指引。這些實(shí)例使得開(kāi)發(fā)者能夠更快地實(shí)現(xiàn)模型的構(gòu)建和訓(xùn)練,降低走彎路的概率。眾多在線(xiàn)社區(qū)和開(kāi)源項(xiàng)目也廣泛傳播這些代碼,促進(jìn)了開(kāi)發(fā)者之間的溝通和知識(shí)共享。

技術(shù)深水區(qū)挑戰(zhàn)

目前的技術(shù)發(fā)展遭遇了一些挑戰(zhàn)。首先,它需要大量的計(jì)算資源,訓(xùn)練一個(gè)大型模型往往需要眾多計(jì)算設(shè)備和能源支持,這直接導(dǎo)致了成本的大幅上升。其次,數(shù)據(jù)隱私和安全問(wèn)題同樣十分關(guān)鍵,因?yàn)槟P陀?xùn)練需要依賴(lài)大量數(shù)據(jù),而如何確保這些數(shù)據(jù)不被泄露,則成為了一個(gè)亟待解決的難題。

針對(duì)這些問(wèn)題,研究團(tuán)隊(duì)正在積極探索解決方案。他們致力于研發(fā)更加高效的算法,以減少計(jì)算資源的浪費(fèi);并且什么是AI大模型?從入門(mén)到精通,一篇文章全搞定,他們還采用了加密和匿名化手段AI模型,保障了數(shù)據(jù)隱私和安全的雙重保護(hù)。盡管遇到了不少困難,大家依然保持著樂(lè)觀的心態(tài),全力應(yīng)對(duì)挑戰(zhàn)。

在人工智能大型模型快速進(jìn)步的背景下,你在執(zhí)行具體項(xiàng)目時(shí),是否遇到過(guò)與運(yùn)用大型模型相關(guān)的一系列挑戰(zhàn)?假如您覺(jué)得這篇文章對(duì)您有所啟發(fā),不妨點(diǎn)個(gè)贊AI模型,并且分享出去!

還沒(méi)有評(píng)論,來(lái)說(shuō)兩句吧...