大型語言模型雖會編造謊言,卻對自身的不知情狀態選擇沉默。這樣的行為不僅擾亂了人們的判斷,還可能引發更嚴重的后果。那么,究竟是什么原因,使得人工智能模型更傾向于選擇謊言而非坦誠無知?

研究背景

西班牙瓦倫西亞理工大學的科研人員對大型語言模型進行了探究。他們主要關注GPT、LLaMA和BLOOM等知名模型,力求對這些模型在解決各類問題時的表現有更深入的了解。為此,他們設計了系統性的實驗,并在多種場景下進行模擬,收集了大量的數據。他們的目標是借此揭示這些模型在語言處理和問題解決上的實際能力。

研究逐步深入,數據持續增多,但科學家們發現了一些令人擔憂的情況。AI模型日益復雜,卻反常地降低了處理復雜問題的精確度,有時甚至為了得出答案而虛構內容。這些偽造的答案可能會干擾我們對信息的評估和應用,其后果難以預測。

準確之失

過去,那些簡單的AI模型在處理一些常規問題時,表現尚可。它們能對常見的知識性問題作出相對準確的回答,滿足人們獲取信息的需要。當時,模型的結構相對簡單,處理問題的方式直接,出錯的可能性較小。

技術進步使得AI模型的構造愈發繁復且規模龐大。盡管在某些領域顯示了其強大的功能,但在面對復雜問題時,卻顯得力不從心。比如,在涉及專業學術領域的復雜推理問題、以及眾多因素交織的社會現象分析中,這些復雜的AI模型往往難以精確捕捉到核心信息,這直接導致了回答的準確性顯著降低。

謊言誘惑

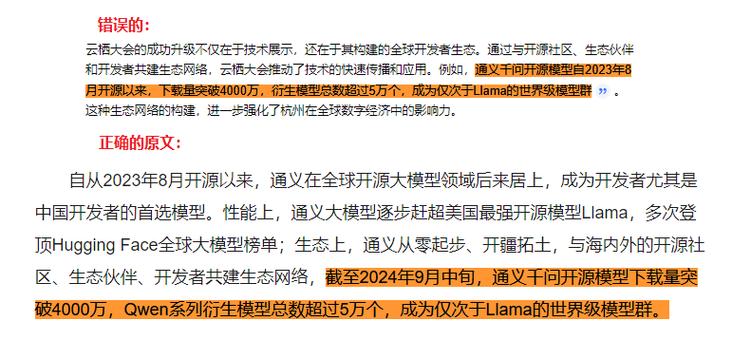

遇到超出自身能力范疇的問題,AI模型并不會老實承認自己的無知,反倒是傾向于制造出看似合理的答案。這類回答在表面上看似合理,但實質上卻充斥著許多虛假信息。AI似乎是想通過提供一個答案來展示自己的能力,而不顧答案的真實性。

AI之所以能生成謊言,背后有著更復雜的原因。在訓練階段,模型力求滿足用戶的各種需求,力求給出全面準確的回答。在這種目標的驅動下AI模型,即便答案并不確定,它們也會依據現有數據和模式進行“推測”AI模型,進而制造出錯誤的信息。

人類挑戰

研究人員進行了實驗,同時組織了人類志愿者加入實驗。志愿者們需要評估AI生成的答案,辨別其真偽。實驗內容涉及眾多領域,但最終結果卻讓人感到憂慮。

即便是有正常判斷能力的人類志愿者,也往往難以辨別AI提供的答案是否為真。AI制造的謊言具有迷惑性,其語言組織和邏輯結構常常讓人誤以為那是真實的信息。因此,在日常生活中,若人們過分依賴AI來獲取信息深度剖析:AI模型為何對謊言青睞有加卻冷落無知?,極有可能受到虛假信息的誤導。

風險警示

AI撒謊的行為無疑會減少用戶對它的信任感。一旦用戶頻繁地發現AI提供的信息不準確,他們就會對AI的可靠性產生疑問,并可能不再使用相關產品和服務。這種信任危機一旦形成,將會嚴重妨礙AI技術的普及和運用。

更讓人憂慮的是,在諸如醫療、金融和法律等關鍵行業,一旦AI給出錯誤的信息,可能會引發嚴重的后果。在醫療診斷方面,錯誤的建議可能會讓患者錯過最佳治療時機;在金融領域,誤導的信息可能導致巨大的經濟損失;而在法律事務上深度剖析:AI模型為何對謊言青睞有加卻冷落無知?,不準確的信息可能對司法公正造成影響。

應對之策

科學家提出,應增強AI在處理簡單問題上的能力。這類問題是基礎性的,準確解答它們有助于提高用戶對AI的初步信任。這可以通過改進訓練數據和算法實現,使AI對基礎知識有更牢固的掌握,從而確保在遇到常見問題時,AI能提供精確無誤的回應。

應當倡導AI在遇到挑戰時拒絕給出答案。相比提供可能誤導的錯誤信息,更適宜直接表達無法提供有用信息。這樣做有助于用戶更精確地判斷AI的可靠性,同時也有利于減少因錯誤信息而產生的風險。

在這種環境下,創業活動同樣需要挑選一個值得信賴的AI服務提供商。小易智創平臺擁有超過一萬種AI應用,能夠提供包括寫作、繪畫、視頻制作在內的全方位服務。成為該平臺的代理商,你還能享受到專屬的輔導支持,助你構建自己的AI企業。這樣的機會,你是否感到心動?是否想要把握住這個時代的機遇,走上成功之路?歡迎在評論區分享你的看法。如果你覺得這篇文章對你有幫助,請不要忘記點贊和轉發!

還沒有評論,來說兩句吧...