AI大模型的信息精確度不容忽視,尤其在關鍵領域,錯誤的資訊可能帶來嚴重后果。那么,我們應當如何來保證其內容的精確度?

邏輯自證陷阱危害

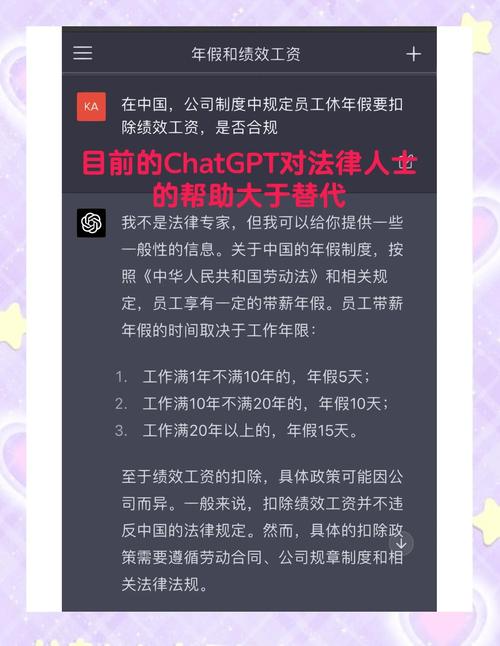

在資本市場、公共健康以及法律法規等關鍵領域中,信息的準確性對各方利益極為關鍵。AI大模型有陷入“邏輯自證陷阱”的風險,這可能導致它們生成看似合理但實際上可能含有錯誤的內容。比如,在金融投資決策方面,如果投資者依賴AI提供的錯誤信息,他們可能會遭受嚴重的經濟損失;而在醫療建議方面,不準確的信息甚至可能危及患者的生命安全。一旦這些錯誤信息在互聯網上傳播,可能會造成誤導。

訓練數據問題根源

多數大型通用模型的訓練材料多取自于公共資源,而非特定行業的數據。這主要是因為行業內部的數據往往是企業重要的競爭優勢。如果企業沒有在本地部署AI大型模型,它們通常不會將這些數據提供給通用大模型使用。以金融科技公司為例,這些公司內部積累的用戶交易數據等敏感信息,一般不會輕易對外公布內容生成時代已至,AI大模型出現幻覺該如何應對?,以便用于大模型的訓練。這一現象使得通用大模型在眾多專業領域的訓練數據量顯得不足。

技術規避要點

陸文韜,作為上海人工智能研究院的算法專家,他提出,在避免AI大模型產生“幻覺”問題上,技術上應重視以下三點。首先,訓練所需的數據需保證其標注來源明確內容生成時代已至,AI大模型出現幻覺該如何應對?,時效性高,引用路徑清晰;其次,選擇準確、可靠的數據來源至關重要,這有助于避免引入偏差和錯誤信息。舉例來說,在醫學信息訓練過程中,應參考權威的醫學期刊和數據庫資料。其次,建立一套行業共用的“幻覺”資料庫,旨在遏制人們接觸那些可能誘發“幻覺”的內容。

實操借鑒方法

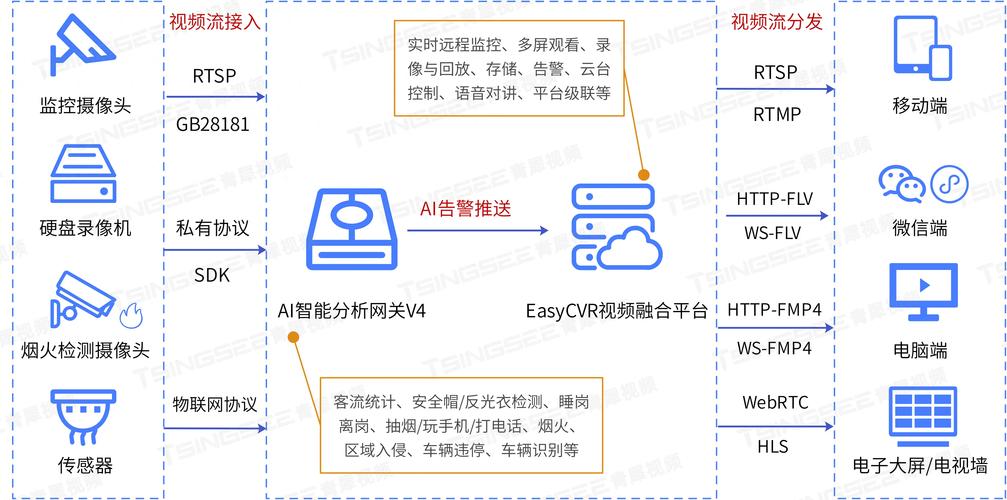

在數據脫敏及加密這一領域,企業能夠運用聯邦學習的方法,達到“數據雖可見卻無法被直接使用”的效果。例如,多個機構協作訓練一個模型,他們之間僅交換模型的參數和梯度信息,而原始數據則得到了妥善的保密處理。關于完善合規工具鏈,企業可以選擇部署自動化敏感信息篩選工具,利用自然語言處理技術來遮擋敏感資料,并且設立智能合約以規范數據的使用權限,例如金融機構能夠利用這一手段來保障客戶資料安全,避免其遭受非法利用。

多主體協同舉措

信息生態的現狀復雜多變,僅憑一種管理手段很難有效遏制虛假信息的蔓延。網絡安全企業和AI搜索引擎平臺需攜手并進,共同構建一個全面的監控系統。這套系統應對涵蓋從語料生成至內容輸出的整個流程進行不間斷的監管。胡麒牧強調AI模型,在AI大模型接收專業語料輸入后,它會不斷自我糾正和調整,旨在確保達到安全的“閾值”。若模型不符合這一標準,則有可能產出虛假內容。

監管應對策略

監管部門現階段對AI大型模型的全面監管還難以實現,但通過設定安全“臨界值”,我們能夠提前對潛在的風險進行評估。在金融、醫療等領域,強制推行官方知識庫的使用,例如國家藥品監督管理局的數據庫。歐盟也明確要求,相關平臺需構建完善的監控機制。部分國際平臺通過技術融合AI模型,增強了識別和攔截虛假信息的能力。

眾人都在琢磨,如何確保那些龐大的人工智能模型的信息準確無誤,未來是否會有更多新穎的方法涌現?歡迎在評論區分享您的觀點,若覺得本文有價值,別忘了點贊并轉發支持一下!