想讓AI模型訓(xùn)練更高效又省錢?關(guān)鍵在于精準(zhǔn)調(diào)整學(xué)習(xí)率!合理優(yōu)化學(xué)習(xí)率,不僅能提升模型性能,還能大幅降低訓(xùn)練成本,實(shí)現(xiàn)成本控制與效果提升雙贏!

AI模型訓(xùn)練中的學(xué)習(xí)率調(diào)整:如何讓模型“聰明”地學(xué)習(xí)?

在AI模型訓(xùn)練的世界里,學(xué)習(xí)率就像是一把鑰匙,它決定了模型如何打開(kāi)知識(shí)的大門(mén),學(xué)習(xí)率調(diào)得好,模型就能快速且準(zhǔn)確地掌握數(shù)據(jù)中的規(guī)律;調(diào)得不好,模型可能就像個(gè)迷路的孩子,在數(shù)據(jù)的海洋里徘徊不前,咱們就來(lái)聊聊AI模型學(xué)習(xí)率調(diào)整的那些事兒,看看怎么讓模型“聰明”地學(xué)習(xí)。

想象一下,你正在教一個(gè)孩子學(xué)數(shù)學(xué),一開(kāi)始,你可能得慢慢教,用簡(jiǎn)單的例子,讓他一步步理解,這就像AI模型訓(xùn)練初期,學(xué)習(xí)率不能太大,否則模型可能會(huì)“跳過(guò)”一些重要的細(xì)節(jié),導(dǎo)致訓(xùn)練不穩(wěn)定,你教孩子加法,如果一開(kāi)始就讓他算三位數(shù)加法,他可能會(huì)一頭霧水,甚至失去興趣,同樣,如果AI模型的學(xué)習(xí)率設(shè)置得太高,它可能會(huì)在參數(shù)空間里“亂跳”,錯(cuò)過(guò)最優(yōu)解。

怎么確定一個(gè)合適的學(xué)習(xí)率呢?這其實(shí)是個(gè)技術(shù)活,得根據(jù)模型、數(shù)據(jù)和任務(wù)來(lái)綜合考慮,我們可以從一個(gè)小值開(kāi)始,比如0.01或者0.001,然后觀察模型的訓(xùn)練情況,如果模型收斂得很快,但最后的結(jié)果不太理想,可能是學(xué)習(xí)率太大了,需要調(diào)小一些;如果模型收斂得很慢,甚至幾乎不動(dòng),那可能是學(xué)習(xí)率太小了,需要調(diào)大一些。

舉個(gè)例子,假設(shè)我們正在訓(xùn)練一個(gè)圖像分類模型,用的是ResNet-50這種深度網(wǎng)絡(luò),一開(kāi)始,我們可以把學(xué)習(xí)率設(shè)為0.001,然后觀察訓(xùn)練過(guò)程中的損失函數(shù)變化,如果損失函數(shù)下降得很快,但最后準(zhǔn)確率不高,我們可以嘗試把學(xué)習(xí)率減半,比如設(shè)為0.0005,再訓(xùn)練一輪看看,如果損失函數(shù)下降得很慢,我們可以嘗試把學(xué)習(xí)率加倍,比如設(shè)為0.002,但這時(shí)候得小心,別讓模型“跳”得太遠(yuǎn)。

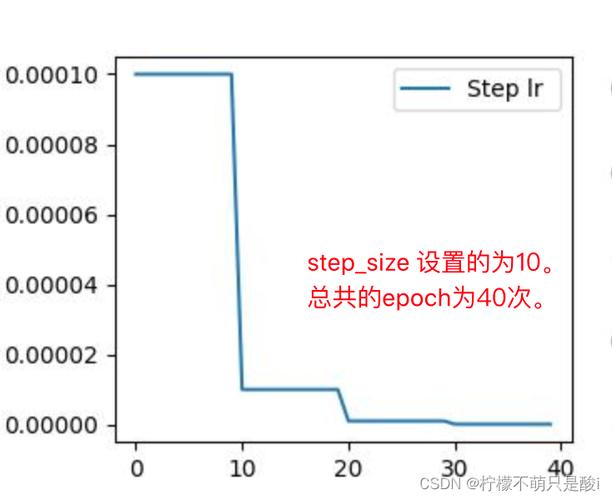

除了手動(dòng)調(diào)整學(xué)習(xí)率,還有一些自動(dòng)調(diào)整的方法,比如學(xué)習(xí)率衰減、學(xué)習(xí)率預(yù)熱和自適應(yīng)學(xué)習(xí)率算法,學(xué)習(xí)率衰減就像是你教孩子學(xué)數(shù)學(xué),隨著他學(xué)得越來(lái)越多,你可以逐漸增加難度,但每次增加的幅度要小一些,在AI模型訓(xùn)練中,學(xué)習(xí)率衰減就是隨著訓(xùn)練的進(jìn)行,逐漸減小學(xué)習(xí)率,讓模型在接近最優(yōu)解時(shí)更加穩(wěn)定。

學(xué)習(xí)率預(yù)熱則是個(gè)比較新的概念,它就像是你先給孩子一些簡(jiǎn)單的題目,讓他熱熱身,然后再逐漸增加難度,在AI模型訓(xùn)練中,學(xué)習(xí)率預(yù)熱就是在訓(xùn)練初期,先用一個(gè)較小的學(xué)習(xí)率訓(xùn)練幾輪,讓模型先適應(yīng)一下數(shù)據(jù),然后再逐漸增加學(xué)習(xí)率,加快訓(xùn)練速度。

自適應(yīng)學(xué)習(xí)率算法則更加智能,它可以根據(jù)模型的訓(xùn)練情況自動(dòng)調(diào)整學(xué)習(xí)率,Adam算法就是一種常用的自適應(yīng)學(xué)習(xí)率算法,它結(jié)合了動(dòng)量法和RMSProp算法的優(yōu)點(diǎn),能夠根據(jù)梯度的一階矩估計(jì)和二階矩估計(jì)來(lái)動(dòng)態(tài)調(diào)整學(xué)習(xí)率,這樣,模型就能在不同的訓(xùn)練階段自動(dòng)調(diào)整學(xué)習(xí)率,達(dá)到更好的訓(xùn)練效果。

學(xué)習(xí)率調(diào)整并不是萬(wàn)能的,即使學(xué)習(xí)率調(diào)得再好,模型也可能因?yàn)閿?shù)據(jù)質(zhì)量、網(wǎng)絡(luò)結(jié)構(gòu)或者訓(xùn)練策略等問(wèn)題而表現(xiàn)不佳,在調(diào)整學(xué)習(xí)率的同時(shí),我們還得關(guān)注其他方面的優(yōu)化,數(shù)據(jù)預(yù)處理得好不好,網(wǎng)絡(luò)結(jié)構(gòu)合不合理,訓(xùn)練策略得不得當(dāng),這些都會(huì)影響模型的最終表現(xiàn)。

在實(shí)際應(yīng)用中,學(xué)習(xí)率調(diào)整往往需要結(jié)合具體的任務(wù)和數(shù)據(jù)來(lái)進(jìn)行,在自然語(yǔ)言處理任務(wù)中,由于文本數(shù)據(jù)的復(fù)雜性和多樣性,學(xué)習(xí)率調(diào)整可能需要更加精細(xì)和靈活,而在計(jì)算機(jī)視覺(jué)任務(wù)中,由于圖像數(shù)據(jù)的結(jié)構(gòu)性和規(guī)律性,學(xué)習(xí)率調(diào)整可能相對(duì)簡(jiǎn)單一些,但無(wú)論如何,學(xué)習(xí)率調(diào)整都是AI模型訓(xùn)練中不可或缺的一環(huán)。

我想說(shuō)的是,學(xué)習(xí)率調(diào)整并不是一蹴而就的事情,它需要我們不斷地嘗試、觀察和調(diào)整,才能找到最適合當(dāng)前模型和數(shù)據(jù)的學(xué)習(xí)率,就像教孩子學(xué)數(shù)學(xué)一樣,你得根據(jù)他的學(xué)習(xí)情況和進(jìn)度來(lái)不斷調(diào)整教學(xué)方法和難度,才能讓模型在訓(xùn)練過(guò)程中不斷進(jìn)步,最終達(dá)到我們的期望。

AI模型學(xué)習(xí)率調(diào)整是個(gè)既有趣又充滿挑戰(zhàn)的話題,它需要我們具備扎實(shí)的理論基礎(chǔ)和豐富的實(shí)踐經(jīng)驗(yàn),才能在這個(gè)領(lǐng)域里游刃有余,希望今天的分享能給大家?guī)?lái)一些啟發(fā)和幫助,讓我們一起在AI模型訓(xùn)練的道路上不斷探索和前行吧!

還沒(méi)有評(píng)論,來(lái)說(shuō)兩句吧...